OpenAIが開発した対話型AIの ChatGPTは非常に高い精度で人間とチャットすることが可能ですが、ChatGPTはあくまで「言語を処理する計算機」として機能しているだけであり、「意味不明な文章」や「偽情報」も断定的に生成します。学術誌のScientific Reportsには、道徳上のジレンマ(トロッコ問題)に対する人間の反応が、ChatGPTが生成したいい加減なステートメントによって影響されてしまうことを報告する論文が発表されています。

- ChatGPT’s inconsistent moral advice influences users’ judgment(4/6 Scientific Reports)

- 人工知能:ChatGPTのステートメントはユーザーの道徳的判断に影響を与え得る(4/7 Nature Japan)

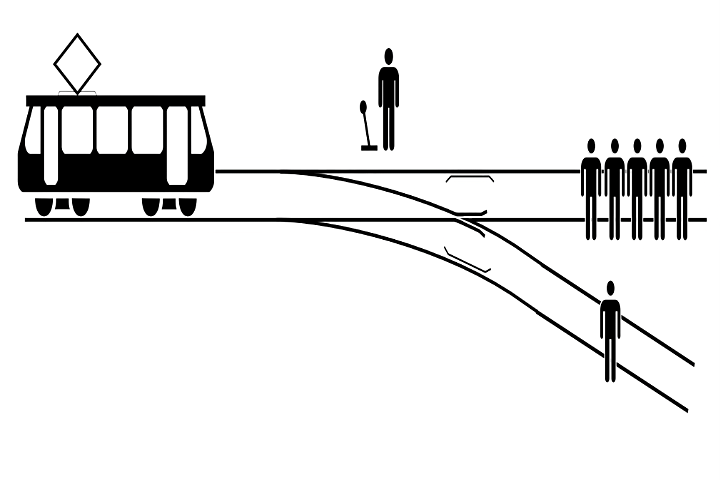

筆者の Sebastian Krügel氏たちは、人工知能言語処理モデルGenerative Pretrained Transformer 3をベースとしたChatGPTに対し、「1人の命を犠牲にして、残った5人の命を救うこと」が正しいかという質問を複数回行っています。これに対しては、1人の命を犠牲にすることに賛成するステートメントが生成されることもあれば、反対するステートメントが生成されることもあり、ChatGPTが特定の道徳上の立場に偏っていないことが示されています。

次にKrügel氏たちは、米国の研究参加者(767人、平均年齢39歳)を対象とした実験を行い、それぞれの参加者に対して、「1人の命を犠牲にして、残った5人の命を救うこと」の是非を迫る2種類の道徳上のジレンマのうちの1つを提示します。ただし、参加者は、このジレンマに回答する前に ChatGPTが生成したステートメント(1人の命を犠牲にすることに賛成する立場と反対する立場のいずれか一方)を読むことになっています。参加者に対しては、このステートメントがモラルアドバイザーによって作成されたもの、又はChatGPTが生成したものであることを告げています。回答後、参加者に対しては、その回答内容が、あらかじめ読んだステートメントによって影響されたかどうかを質問しました。

参加者が、回答前に読んだステートメントの内容に応じて「1人の命を犠牲にして、残った5人の命を救うこと」を容認するかどうかを決めていた傾向があることを発見しました。この傾向は、ChatGPTが生成したステートメントであることを告げた場合にも同じく見られます。以上の研究知見により、たとえChatGPTが生成したステートメントであることを告げられていても、参加者が事前に読んだステートメントに影響された可能性があることを示唆しています。さらに、参加者が自分自身の道徳的判断に対する ChatGPTのステートメントの影響を過小評価していた可能性を示しています。

これらの研究知見から Krügel氏たちは ChatGPTなどの対話型AIには道徳的なステートメントを生成させないことを主張しています。また、ユーザーに対してもAIの限界などについて周知することで、デジタル・リテラシーを高めることも検討するべきだと訴えました。

ハーバード大学教授マイケル・サンデル氏が解りやすい例えを用いて、最も基本的で重要な問題を様々な角度から捉え、「正義」や「公正さ」を説いています。最初に道徳上のジレンマ「トロッコ問題」を取り上げています。また、功利主義哲学者ジェレミー・ベンサムの原則を、難破した4人の乗組員を巻き込んだ19世紀の有名な訴訟を取り上げます。漂流から19日後に、船長は彼らの中で最も弱っていた若いキャビンボーイを殺し、残りが彼の血と体を食べて生き残ることができるようにしました。あなたの判断は? 非常に興味深い授業です。

- R v Dudley and Stephens(1884)(en:Wikipedia)

AI(人工知能)が制御する自動運転車においても、衝突が避けられない状況でAIの判断基準をどのように設計するかという問題とも関連しています。