Googleは、年次開発者会議「Google I/O 2017」で、機械学習に最適化した第2世代の TensorFlow Processing Unit(TPU)と、それを用いたクラウドサービス「Cloud TPU」を発表しました。

サンダー・ピチャイ(Sundar Pichai)CEOは、「機械学習やAIの進化は、コンピュータアーキテクチャの見直しを迫っており、そのためにAIファーストデータセンターを構築している」、また「カスタムハードウェアのTPUは、CPUやGPUよりも15倍から30倍高速で、30倍から80倍も電力効率が高い」と述べています。

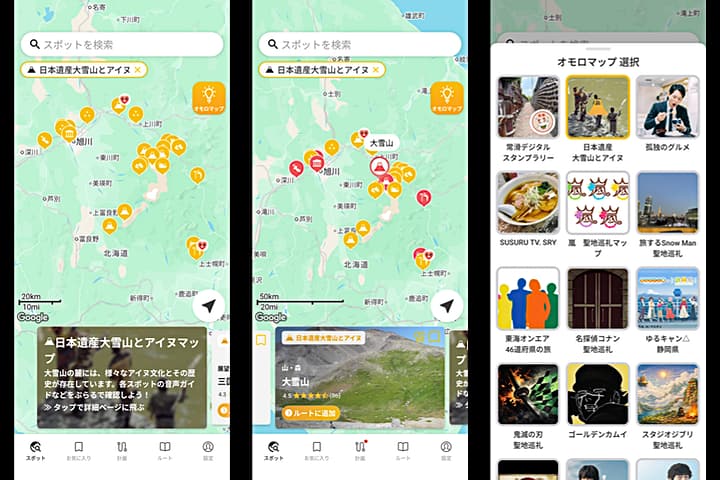

写真は1台の「Cloud TPU」ボードで、ここに4つのチップが搭載され、ボード1つあたり180テラフロップス(1秒間に180兆回の演算)の能力を備えています。

データセンター内では、これを64台まとめた「TPU Pods」を構成し、このポッドあたり 11.5 ペタフロップス(1秒間に1.15京回の演算)の能力があると述べています。

理化学研究所のスーパーコンピュータ「京」は、1秒間に1京回の演算ができることから「京」と名付けられています。

Googleの Jeaf Dean氏によれば、「TPU Pods」の能力の8分の1を使って機械翻訳モデルの学習を処理したところ、「現在販売されている最速の GPUを32個使った場合に丸1日かかった処理が、TPUポッドでは同じ翻訳精度を保ったまま午後には処理が終了するようになった」と説明しています。

- Google I/O’17: Google Keynote(YouTube)

- 中学生にも分かるTensorFlow入門 その1 テンソルとはなにか(qiita.com)