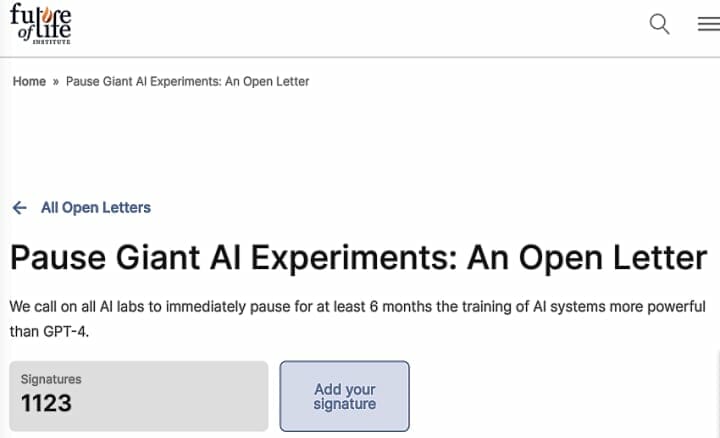

3月28日、AI(人工知能)の安全性について研究する非営利の研究組織 Future of Life Institute(FLI)は、GPT-4よりも強力なAIシステムの開発と運用を少なくとも6カ月間停止するように呼びかける書簡を公開しています。イーロン・マスク氏や、米Appleの共同創業者スティーブ・ウォズニアック氏、「サピエンス全史」で知られる作家のユヴァル・ノア・ハラリ氏の名前もあり、3月30日現在1,368人が署名しています。この一時停止は「公開され、検証可能」なものでなければならず、すべての主要な関係者を含むものでなければならないと公開書簡は述べ、あまりにも遅かったり、停止しようとしなかったりする場合は、この問題に「介入」するよう政府に促しています。

- Pause Giant AI Experiments: An Open Letter(3/22 FLI)

- マスク氏ら、AI開発の一時停止訴え 安全性の確立優先(3/28 ロイター)

この数カ月間における速いペースでのAI研究の進展は、抜本的な対策の必要性を強く示唆していると述べています。「研究は制御不能な競争に陥っており」、ますます強力なシステムを開発しているが、そのシステムを理解、予測、制御することは、その作成者を含めて誰もできないとしています。

研究所と独立した専門家は、外部の専門家が監査・監督する一連の共有安全プロトコルを開発するためにこの期間を利用すべきであり、それによってAIシステムが「合理的な疑いを超えて安全である」ことを確認するべきだと、公開書簡は述べています。

- 汎用人工知能による人類滅亡のリスク(Wikipedia)

- Existential risk from artificial general intelligence(en:Wikipedia)

米国のOpenAIが開発した人工知能チャットボットChatGPTの成功をきっかけに、新しいAI製品の市場投入が急がれています。テック業界の大手企業や無数のスタートアップが、この分野全体の将来を左右しかねない急成長する市場で、その地位を確保しようとしのぎを削っており、より高性能な製品の開発に取り組んでいます。

性能だけを追求して開発競争しているAIシステムは、既存の偏見や不平等を悪化させ、誤った情報を広め、政治や経済を混乱させ、「詐欺」「デマ」「サイバー犯罪」などに悪用するハッカーを助けていると専門家は警告しています。長期的には、AIは人類に存亡の危機をもたらすと警告する専門家もいます。

- AIの悪用と犯罪(Google検索)

- ChatGPTなどの優れたチャットボットAIがいかに犯罪に使われやすいかをユーロポールがまとめて公開(3/29 GIGAZINE)

OpenAIに多額の投資をしているマイクロソフトの創業者で元CEOビル・ゲイツ氏は署名していませんが、最近のブログ(The Age of AI has begun)でマスク氏らが署名した公開書簡で提起されたのと同じ問題の多くを指摘しています。ゲイツ氏は、AIを取り巻く社会的な懸念は、政府と技術を推進する民間企業の間で解決されるべきであり、その技術が良い方向に使われるようにする必要があると述べています。

- マスクらが人類へのリスクを考慮しAI開発の「一時停止」呼びかけ(3/30 Forbes JAPAN)

- 42カ国がOECDの人工知能に関する新原則を採択(5/22 2019 OECD) 参考

<追記:4月1日>

FLIでは大学の研究者や OpenAIとともに、米アルファベット傘下の Googleと DeepMindの現役従業員と元従業員を含めた専門家が手がけた計12の研究を引用しています。うち研究が引用されたAI専門家4人がこの公開書簡に懸念を表明しました。

- AI専門家ら、マスク氏らの公開書簡に懸念(4/1 ロイター)

人工知能チャットボットChatGPTをめぐっては、AIの専門家に限らず、数多くの公的機関や一般市民が「倫理規則」や「運用」に疑念・懸念を抱いており、「研究は制御不能な競争に陥っている」や「偽情報」や「ステレオタイプ」の拡散、さらに「悪用」や「個人情報保護」「著作権侵害」などを含めて、公的機関の場で公開討論が必要と思います。