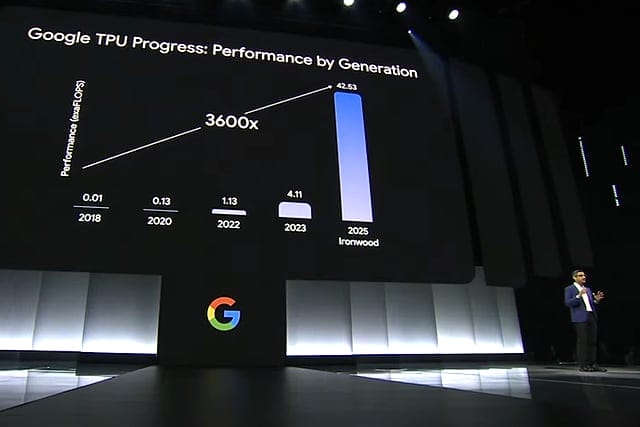

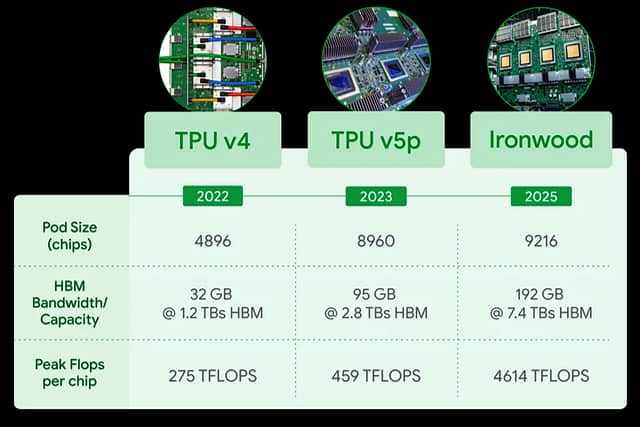

Googleは、4月9日のGoogle Cloud Next 25で、第7世代TPU(Tensor Processing Unit)となる「Ironwood」を発表しました。大規模な思考型推論AIモデルを実現するために特別に設計された初のアクセラレータです。1PODあたり9,216チップ、合計 42.5エクサflopsに拡張すると、Ironwoodは世界最速のスパコンであるEl Capitanの24倍以上の演算能力をサポートします。

- Ironwood: The first Google TPU for the age of inference(4/9 Google)

- Google Cloud TPU で AI開発を加速する(Google Cloud)

Ironwoodは、AIの発展とその進歩を支えるインフラにおける大きな転換を象徴しています。人間が解釈するためのリアルタイム情報を提供するレスポンシブなAIモデルから、洞察と解釈をプロアクティブに生成するAIモデルへの移行です。これは私たちが「推論の時代」と呼ぶもので、AIエージェントがプロアクティブにデータを取得・生成し、データだけでなく洞察と答えを協調的に提供する次世代AIです。

Ironwoodは、大規模言語モデル(LLM)、Mixture of Experts(MoE)、高度な推論タスクなどを含む「思考モデル」の複雑な計算、および通信要求をスムーズに処理できるように設計されています。これらのモデルでは、大規模な並列処理と効率的なメモリアクセスを必要としています。Google Cloud では、AIワークロードの需要に基づいて、256チップ構成と9,216チップ構成の2つのサイズで提供されます。

1PODあたり9,216チップ、合計 42.5エクサflopsに拡張すると、Ironwoodは世界最速のスパコンであるEl Capitanの24倍以上の演算能力をサポートします。Ironwoodは、学習と推論のための思考機能を備えた超大規模高密度LLMやMoEモデルなど、最も要求の厳しいAIワークロードに必要な、大規模な並列処理能力を提供します。個々のチップでは、ピーク時で 4,614テラFLOPSの演算能力を誇ります。

Gemini2.5やノーベル賞を受賞した AlphaFold といった最先端の思考モデルは、現在すべて TPU上で動作しています。Ironwoodは演算能力、メモリ容量、ICIネットワークの進化、そして信頼性の向上により、推論の時代における比類なきブレークスルーを実現します。

世界中の組織が革新的なソリューションで変革を推進し、効率性を高め、従業員のエンパワーメントを図り、顧客エンゲージメントを高め成長を促進しています。Google Cloud CEOの Thomas Kurian氏によるオープニング基調講演では、AIのブレークスルーに関する洞察と、世界中のお客様やパートナーの成功事例を紹介しています。